-

Broj sadržaja

45781 -

Na DiyAudio.rs od

-

Broj dana (pobeda)

590

Content Type

Profiles

Forum

Blog

Kalendar

Sve objavljeno od Mikorist

-

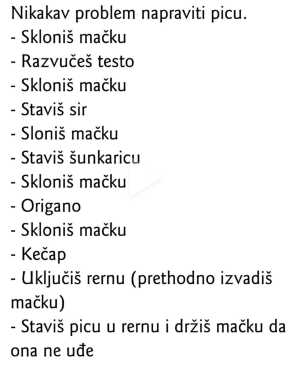

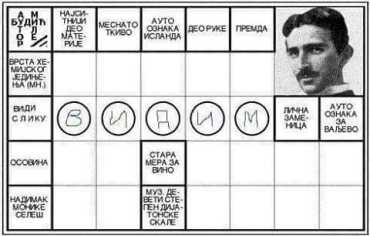

Zanimljive, smešne i čudne fotografije

Mikorist je odgovorio/la Mikorist's temus u Muzika , Film i Fotografija

-

Zanimljive, smešne i čudne fotografije

Mikorist je odgovorio/la Mikorist's temus u Muzika , Film i Fotografija

-

Zanimljive, smešne i čudne fotografije

Mikorist je odgovorio/la Mikorist's temus u Muzika , Film i Fotografija

Red, mir i tišina. Nije to bio samo natpis u domovima zdravlja, već pravilo postojanja. Skoro monaško. Skoro ašramsko. Sećam se voštanog mirisa ispoliranih hodnika i zelenog linoleuma koji je upijao korake i vraćao tišinu. I škole su disale istom čistoćom. Danas taj miris opstaje još samo u velikim tržnim centrima, ali bez reda, bez mira i bez tišine. -

Zanimljive, smešne i čudne fotografije

Mikorist je odgovorio/la Mikorist's temus u Muzika , Film i Fotografija

Pucamo za praznike. Ne da slavimo. Ne da se radujemo. Pucamo da ubijemo tišinu. Sa živcima. Po šavovima. U visine. Najčešće u prazno. Odjekne prasak. I u njemu ne puca petarda. U njemu puca samo praznina u nama. -

Zanimljive, smešne i čudne fotografije

Mikorist je odgovorio/la Mikorist's temus u Muzika , Film i Fotografija

-

Evo još jedan - kod drugara snimljeno.

-

Šta da radim kad je na gramofonu

-

Evo kako je kod mene išlo… svaki Topping ili SMSL koji sam zakačio na PC u zgradi sa nekih 90 stanova je totalno tiltovao. Znaš ono… smetnje na sve strane.... kroz HDMI, mobilne, sam komp, sve što ima neki digitalni signal. Šta god sam okretao...fazu, utikače, produžne, samo bi na trenutak proradilo, pa opet haos. Sve je delovalo normalno, struja kako treba, ali DAC je znao da izgubi link ili da me nervira čim se nešto pomeri. Praktično sam skontao da problem ide preko USB-a i zajedničke mase, a ne preko napajanja samog DAC-a. Smetnje su posebno osetne kad su mobilni ili monitor blizu....preskače ili se pojavi ono poznato zujanje kad telefon šalje poruku ili zazvoni.Onaj „GSM buzz“, „bumblebee“ zvuk, kao „dit dit dit“, „tdk tdk tdk“, brzo pulsirajuće brundanje, kao pčela u zvučniku. To je čista radio-smetnja od GSM-a, oko 217 Hz, i kad sistem nije dobro sređen, on to lepo uhvati i pusti pravo u zvuk. Pavouk DAC je totalno druga priča. Šasija lepo uzemljena, masa pod kontrolom, torusni trafo sa elektrostatickim štitom, RC snubber, Amanero USB-I2S sa dobrim klokovima, reclocking-om. Plus, nema digitalnog filtera koji bi ubacio još šuma. Rezultat je da svo to digitalno smeće i smetnje sa PC-a jednostavno ne ulaze u analognu sekciju i sve ostaje mirno, bez ikakve drame, čak i kad je telefon bukvalno na DAC-u. Moderni ultra-low-noise DAC-ovi sa širokim bandwidth-om baš piju svaku smetnju koja ide preko USB-a i mase, dok stari dobri R-2R DAC, ako je šasija uzemljena i masa sređena, ostaje imun i u najzagađenijim instalacijama. Okretanje utikača ili igranje sa zemljom može na kratko da smiri buku, ali dugoročno ne vredi i nije bezbedno. Povećavanje osigurača na 30A je apsurd i opasno po život. Ako hoćeš da ti svira stabilno, moraš sve da sređuješ sistematski: PC i HDMI da ne prosipaju smetnje, masa da bude čista i pravilno povezana, praviš DIY DAC da se ne rasipa signal, eventualno izolacioni trafo ili USB izolator, i PO89ZB - DC filter za svaki SMPS. Nema prečica , moraš da vodiš računa o tome kako se masa šeta kroz sistem i gde ulazi smetnja, inače se svaka promena odmah čuje u zvuku. P.S. Ovo pišem prvenstveno kao informaciju za ljude koji tek ulaze u priču i mogu da nalete na isti problem. Ko već ima svoj ustaljen način mišljenja, verovatno će i dalje ići po starom (ekser kao osigurač). Ovo nije pokušaj da se bilo kome nameće kao rešenje.

-

Ovo je opasno po život. Može da bude ealan uzrok požara , naročito u zgradama sa starim instalacijama 30–50 godina.

-

Zanimljivi & smešni na You Tube

Mikorist je odgovorio/la Leonardo's temus u Muzika , Film i Fotografija

-

^ VoT

-

Da… zato hi-end slušalice jebu kevu za starije osobe. Trebaju ti zvučnici od 120 dB da čuješ na 5 metara sa 70+ godina… ili one slotije koje pominje Zen za bioskope … ili da sediš na metar od zvučnika i nabijen u TV i čitaš im sa usana vesti.

-

Zanimljive, smešne i čudne fotografije

Mikorist je odgovorio/la Mikorist's temus u Muzika , Film i Fotografija

-

Ona normalno radi sa TA peći bez varničenja jer je dizajnirana za ozbiljnije struje (debeli bakarni kontakti, solidna provodljivost, ima keramičko jezgro u utičnicama), nisu kao one kineske jeftine letve

-

Ako vrganj zagrejem do 70°C, bukovača dobije Bluetooth, a tartuf pored gramofona sluša Žilavku, hoće li mi kabl početi da peva dok jedem teletinu?

-

Zanimljivi & smešni na You Tube

Mikorist je odgovorio/la Leonardo's temus u Muzika , Film i Fotografija

Sora, OpenAI -

Zamolio sam ChatGTP da iskenira sve @Zen Mod postove i napi[e u njegovom stilu odgovor Evo jedne verzije u Zen Mod / diyaudio.rs fazonu Ne budi se čovek pre 12h…… Red rakije…… red lemilice…… pa tek onda kafa…… Pre toga…… nema filozofije…… nema kablova…… nema istine…… Sve to „toplo“… „organsko“… „sa dušom“… „srebro što peva“… „bakar što miriše na detinjstvo i bakin špajz“… Ajde bre…… Ne kenjaj…… Nije to u kablu…… Nije u 7N…… 8N…… OCC…… monokristalu…… Litzu…… cryo tretmanu…… kvantnoj fazi Meseca…… niti u tome što je neki lama šaptao mantru kablu tri dana dok je ovaj ležao na 432 Hz…… To je sve lepo za pričanje uz kafu…… ali elektronika se na to samo kiselo nasmeje…… Prava stvar je jedna…… i zove se…… mirna struja…… Ne histeriše…… ne talasa…… ne kašlje…… ne povraća ripple na 50 Hz…… Ne dere se kroz napajanje kao dete u prodavnici igračaka…… Miruje…… Kao deda koji sedi ispred dragstora u 7:10…… popio prvu rakiju…… i sad mu je ceo svet taman…… Kad ti napajanje igra kolo kao pijani kum na svadbi…… kad ti SMPS ili MPPT pravi šum kao fića na leru…… gas do daske…… možeš ti tu da staviš kabl od čistog srebra iz Teslinog pepela…… sviraće isto…… tanko…… nervozno…… i iritantno…… kao radio kroz megafon iz ’92…… Kabl je…… bre…… žica…… Komad metala koji prenosi struju…… Tačka…… Na 20 Hz…… 20 kHz…… razlika između bakra i srebra je toliko mala…… da je vidiš samo ako ti je smrtno dosadno…… i imaš FFT koji košta kao polovan auto…… Sve ostalo je mašta…… i samoubeđivanje…… Duša ne dolazi iz kabla…… Duša dolazi iz teškog trafoa…… iz kondenzatora koji imaju kilažu…… iz regulatora koji su smireni…… i znaju gde im je mesto…… iz mase koja je masa…… iz GND-a koji nije filozofija…… nego zakon…… Toplina…… vazduh…… scena…… holografija…… crnina kao bezdan…… Ili su to merljive stvari…… THD+N…… PSRR…… jitter…… IMD…… noise floor…… ili je marketing za sirotinju duha…… koja hoće da veruje…… da je problem u kablu…… a ne ispod haube…… Znači…… kratko…… i bez patetike…… Ne traži dušu u kablu…… Traži je tamo gde struja prestaje da se nervira…… Kad napajanje dođe u zen…… muzika će sama da dođe u red…… A do tada…… menjaj kablove koliko hoćeš…… Biće isto…… Samo će da košta više…… Čitam ovo…… pijem sok…… i umalo da mi monitor dobije tuš iz nozdrva……

-

Sinusni talas… ne može biti „mekan“… ili je pravi sinus… ili nije. Ono što mi doživljavamo kao „mek“ zvuk… zapravo potiče od stabilnog napajanja… malog šuma… niskih intermodulacija… kvalitetnih japanskih kondenzatora… i dobre otpornosti napajanja na šum (PSRR)… Moderni solarni sistemi… ovakvu stabilnost po pravilu nemaju… Solarni panel daje nestabilni DC napon… sa puno ripple-a… MPPT kontroleri i inverteri uvode kHz prekidanja… EMI smetnje… harmonike… Baterije dodaju svoj šum… i starenje… A izlazni AC… je PWM talas filtriran tako da izgleda kao sinus… ali… to je samo približna simulacija… Prava stabilnost… dolazi iz stare škole… Masivan 50 Hz transformator… sa elektrostatičkim štitom… Pravilno dimenzionisan snubber… kvalitetan ispravljački most… veliki elektrolitski kondenzatori… lokalna regulacija… kratke povratne linije… kontrolisane povratne petlje… Tu nema magije… niti „audiofilskog marketinga“… Problem moderne audio-prakse… je rasipanje energije signala… Nivo signala… se nepotrebno smanjuje… bez ikakve transformacije… Potenciometri u seriji… prave uska grla… Gomila elektrolita… stoji u signalnom putu… PCB i ožičenje… nisu dobro projektovani… Već u DAC-u… signal se deli… i gubi u toplotu… Više od polovine energije… nestane… pre nego što dođe do kraja lanca… Rezultat… mrtva dinamika… Još u DAC-u… stvara se oštrina zvuka… čak pre samog čipa… veštačkim „digitalnim“ karakterom… Brickwall digitalni filteri… imaju strm prelaz… između propusnog i zabranjenog opsega… Što u blizini granične frekvencije… izaziva neprirodna fazna pomeranja… i lošu prostornu sliku… Pojavljuje se i pre-ringing… mali impulsi… pre stvarnog signala… veštački odjek… koji uho registruje kao metalan… neprirodan ton… tzv. digititis… Zato… su mi draži stari DAC čipovi… Čak i bez digitalnih filtera… sa minimalnom obradom… i očuvanjem energije signala… Manje intervencija… znači manje „laži“ u zvuku… To je i razlog… zašto koristim Pavouk DAC… što je detaljno objašnjeno… na forumu…

-

Strujna letva, utičnica ili audiofilska viljuška mogu uticati na sistem ali samo u okviru zakona fizike....... Ako poslednjih jedan ili dva metra strujnog puta napajanje prolazi kroz: stotine kilometara dalekovoda do Đerdapa i Obrenovca....... transformaciju sa srednjeg na niski napon....... osigurače i oksidirane kontakte, aluminijumsku instalaciju....... komšije sa inverterima, SMPS-ovima, frižiderima, motori od liftova......... i onda verujemo da se na poslednjem centimetru bakra odjednom pojavljuje: „vazduh koji duboko diše kroz grlo“....... „mesinganost činela“....... „drvo koje titra“............ to nije kompliment viljuški...... nego optužnica za ceo sistem....... Ako promena letve ili viljuške: menja tonalni balans....... „omekšava“ zvuk....... produžava ton....... menja teksturu instrumenata.......... Napajanje u uređaju (ili više njih) nije adekvatno projektovano jer aparat ne treba da reaguje homeopatski na struju....... To je dijagnoza za kablomaniju....... Dobrodošao u klub......

-

Zanimljive, smešne i čudne fotografije

Mikorist je odgovorio/la Mikorist's temus u Muzika , Film i Fotografija

-

Trenutno na sajtu 2 članova, 1 Skrivenih, 19 Gosta (Pogledaj celu listu)

-

Forumska statistika

9.1k

Ukupan broj tema448.2k

Ukupan broj objava -

Statistika članovȃ